La corsa all’impiego dell’analisi dei dati strutturati, per migliorare la capacità di decisione nelle organizzazioni, ha probabilmente raggiunto un punto di svolta simbolico quando Microsoft ha inserito due algoritmi (decision treees e clustering) di data mining in Sql Server 2000.

Sembra questo un segnale importante del processo di accettazione di una tecnologia e di un metodo (e dei servizi necessari per utilizzarli) assai complessi e dai costi spesso proibitivi e fino a qualche anno fa applicabili solo in poche aziende.

Ora i maggiori database fanno della business intelligence, data mining compreso, uno dei maggiori punti di forza.

Ma è dunque vero che il data mining (Dm) è diventato «popolare»?

Una risposta relistica probabilmente è: sì, ma solo in parte.

Le applicazioni commerciali che lo utilizzano in effetti sono " almeno potenzialmente " numerose (cfr. l’articolo qui sotto) e per i responsabili dei progetti di business intelligence le funzioni di questo tipo direttamente vendute con l’engine cominciano a essere fra i fattori di valutazione dei database.

Tuttavia i costi e la complessità sono tutt'altro che irrilevanti, e vanno ben oltre il «motore».

Intanto, se è vero che in Sql Server il data mining, come l’Olap, è compreso nel prezzo, in Oracle, per esempio, è ancora un extra e piuttosto costoso.

E dalle differenze emergono anche le diverse ambizioni di portata funzionale dei due strumenti, con Microsoft a proporre quasi un «assaggio».

Infatti, la data mining option per Oracle 9i costa 20 mila dollari per cpu (l’enterprise edition del database ne costa 40 mila, e altri 20 mila dollari costa l’Olap option).

Soprattutto (e vale anche per Microsoft), la natura dell’analisi tipica del mining " «discovery driven», alla ricerca di relazioni sconosciute e inattese fra variabili anche molto numerose (altrimenti definito proprio knowledge discovery) " richiede progetti complessi, software aggiuntivi, sviluppo su misura, adattamenti organizzativi, personale molto specializzato, consulenti all’altezza, enormi quantità di dati da trattare e hardware più potente di una «semplice» soluzione per le query ad hoc o l’Olap.

Un'occhiata a qualsiasi documento metodologico di sintesi dedicato all’implementazione del data mining (basta fare una ricerca sul sito di una rivista specializzata come DmReview per rendersene conto) mostra la quantità e l’intreccio fra i fattori in gioco sul piano strategico e su quello tecnico: identificazione degli obiettivi di business da raggiungere; disponibilità della tipologia di dati giusta e di qualità adeguata (aspetto decisivo per ogni data warehouse ma più radicale quando si fa Dm) e in quantità sufficiente; interrelazione fra il personale dell’It e chi deve effettuare le analisi.

E questa lista si può allungare facilmente.

A ciò si deve poi aggiungere che la premessa indispensabile al successo di un progetto è proprio il fatto che il data mining sia necessario e giustificato: definire con precisione quando bastano applicazioni di query e reporting o di Olap e quando invece serva il data mining è già un'operazione decisiva.

E sovente i due tipi di analisi - per aggregati e induttive - vanno combinati, perché complementari, accrescendo però la complessità del progetto.

In definitiva il Dm può essere definito più popolare perché le aziende oggi hanno più spesso bisogno delle analisi che esso consente.

E non perché i costi e i rischi complessivi di un progetto adeguato siano alla portata di piccoli bilanci o comunque votati al risparmio.

Ultimi Articoli

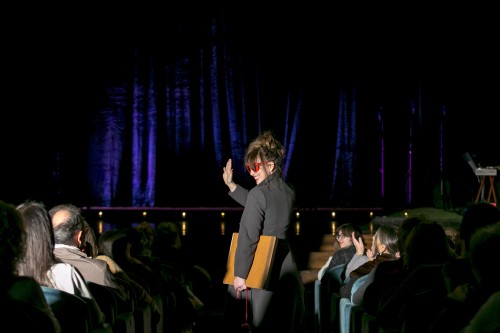

Mummenschanz: 50 anni di poesia silenziosa in scena al Teatro Menotti di Milano

Milano — I colori dei bambini per la pace a Milano Cortina 2026

Amazon sotto la lente del Garante Privacy — Telecamere, dati e diritti nei magazzini italiani

Ma il vishing è storia vera? Prefisso +34 e chiamate dall’estero — Attenti, la vostra voce può diventare un clone

Alexia torna a Città del Messico — confermata alla line-up di EDC Mexico 2026

Milano Cortina 2026 — Una rete diffusa di media centre porta i Giochi nel territorio

SOMBR — esce il singolo ''Homewrecker'' mentre parte il tour sold-out europeo con tappa a Milano

Fan Village Milano Cortina 2026 aprono al pubblico — dove e come partecipare

FORTE e CHIARA al Teatro Carcano di Milano